分类: AI

通过WPeMatico自动添加.

-

Luma releases a new AI model that lets users generate a video from a start and end frame

Luma AI’s new model is available through the company’s Dream Machine platform. -

Vibe-coding startup Lovable raises $330M at a $6.6B valuation

Lovable has seen its valuation more than triple just five months after the company’s last funding round in July. -

Amazon’s new Alexa+ feature adds conversational AI to Ring doorbells

Amazon said that the feature uses the Ring doorbell’s video descriptions to determine who the person in front the camera is based on their uniform, actions, and what they are holding. -

个体能在AI中突围吗?

AI技术的爆发式发展正在改写职场规则与商业逻辑。从2022年的’寒气传递’到如今的AI变现风口,超级个体的崛起揭示了一个残酷真相:技术降低了专业门槛,却放大了执行力的差距。本文将深度剖析AI时代下’一人公司’模式的可行性,揭示那些被忽视的变现门槛与底层逻辑。

2022年8月份,有一句话在互联网上光速传播:把寒气传递给每个人。

这句话的影响力,有多大?

依然清楚的记得,当时的老板为此单独组织全公司开会,云里雾里的说了很多,其实投资领域的公司,很多趋势都看得明白。

意思很明确:勒紧钱包讨生活。

当时ChatGPT还没有爆火,半夜没有很多王炸模型发布,也没有标题党整天说,不买AI课程,就可能被淘汰。

职场内卷的主题还是:多学技能做六边形战士。

2022年底ChatGPT爆火,到2025年底,人工智能依然是热搜榜常驻嘉宾,任何风吹草动,都可能被渲染成历史时刻。

从时间线上看,寒气不完全由AI导致。

人工智能的快速发展,叠加这几年裁员的新闻,正好形成了非常混乱的十字路口,头部公司在卷模型参数和跑分,用户在卷AI玩法和流量。

由此重新带火的概念:超级个体或一人公司。

作为花过一分钱买资料的韭菜,看过超级个体的模式:靠一个人和AI助手完成:产品,知识,内容,管理等各个维度的事情。

用一句大白话说:借助AI打造自媒体,然后做流量变现。

这四个板块在企业里都是难题,由专业的团队运作,也很难轻易拿到成果,交给个人来执行,反而成了AI热潮中的一个风口。

人工智能助推裁员的趋势,同时又带来机遇。

这算不算:开了一扇门,又开了一扇窗?但是门有门槛,窗户有窗台,出了门之后,想从更高的窗台进屋,并非容易的事。

不论企业还是个人,变现的基础是:一手产品和一手用户。

如何给产品处心积虑的设计卖点,才会吸引更多的用户为此付费,这是拦住很多项目商业化的核心难题。

在一人公司的模式中:追求做大流量做小产品。

流量足够大的前提之下,产品无论软件硬件,还是知识付费,亦或是咨询服务,总会有更高的销售概率。

哪怕以最低价格卖出去一份,也算是商业路径打一圈。

这里面有三道很难跨越的门槛:自媒体保证持续的流量,设计可销售的产品,稳定之后还要逐步扩大,做成养活自己的公司。

先摆摊再开店,最后还要冲进商圈。

这些难题如果个人都能解决,那么在企业里打一圈都不成问题。

在目前的环境里,从心底认可两个群体,一个是曾经抓住自媒体风口,另一个是抓住现在AI变现的风口,既需要眼光,又需要坚定的心态。

这两个群体,有很多相似性。

AI降低各种专业技能的门槛,必然会放大个体的执行力,人和人之间的能力差距,反而会被拉大,很多想法和思路,可以快速的出样品,放在流量渠道验证。

现在的AI:当然会做内容,当然也会做产品,当然还会做运营。

但是不具备,从根本解决问题的能力。

内容找什么角度,产品用什么创意,如何通过运营手段,把产品销售出去,这些事想一想说一说,似乎都不是那么难。

唯独自己一上道,发现每一步都没有确定性。

从本质上理解,当下的AI对于普通人来说,更多是提高效率,并没有创造需求,这场技术变革中,以通用智能的角度看,还处于刚开始的阶段。

先置身其中,再不断的寻找确定性。

本文由 @李召羊 原创发布于人人都是产品经理。未经作者许可,禁止转载

题图来自Unsplash,基于CC0协议

该文观点仅代表作者本人,人人都是产品经理平台仅提供信息存储空间服务

-

Bursting AI bubble may be EU’s “secret weapon” in clash with Trump, expert says

The US threatened to restrict some of the largest service providers in the European Union as retaliation for EU tech regulations and investigations are increasingly drawing Donald Trump’s ire.

On Tuesday, the Office of the US Trade Representative (USTR) issued a warning on X, naming Spotify, Accenture, Amadeus, Mistral, Publicis, and DHL among nine firms suddenly yanked into the middle of the US-EU tech fight.

“The European Union and certain EU Member States have persisted in a continuing course of discriminatory and harassing lawsuits, taxes, fines, and directives against US service providers,” USTR’s post said.

-

Google releases Gemini 3 Flash, promising improved intelligence and efficiency

Google began its transition to Gemini 3 a few weeks ago with the launch of the Pro model, and the arrival of Gemini 3 Flash kicks it into high gear. The new, faster Gemini 3 model is coming to the Gemini app and search, and developers will be able to access it immediately via the Gemini API, Vertex AI, AI Studio, and Antigravity. Google’s bigger gen AI model is also picking up steam, with both Gemini 3 Pro and its image component (Nano Banana Pro) expanding in search.

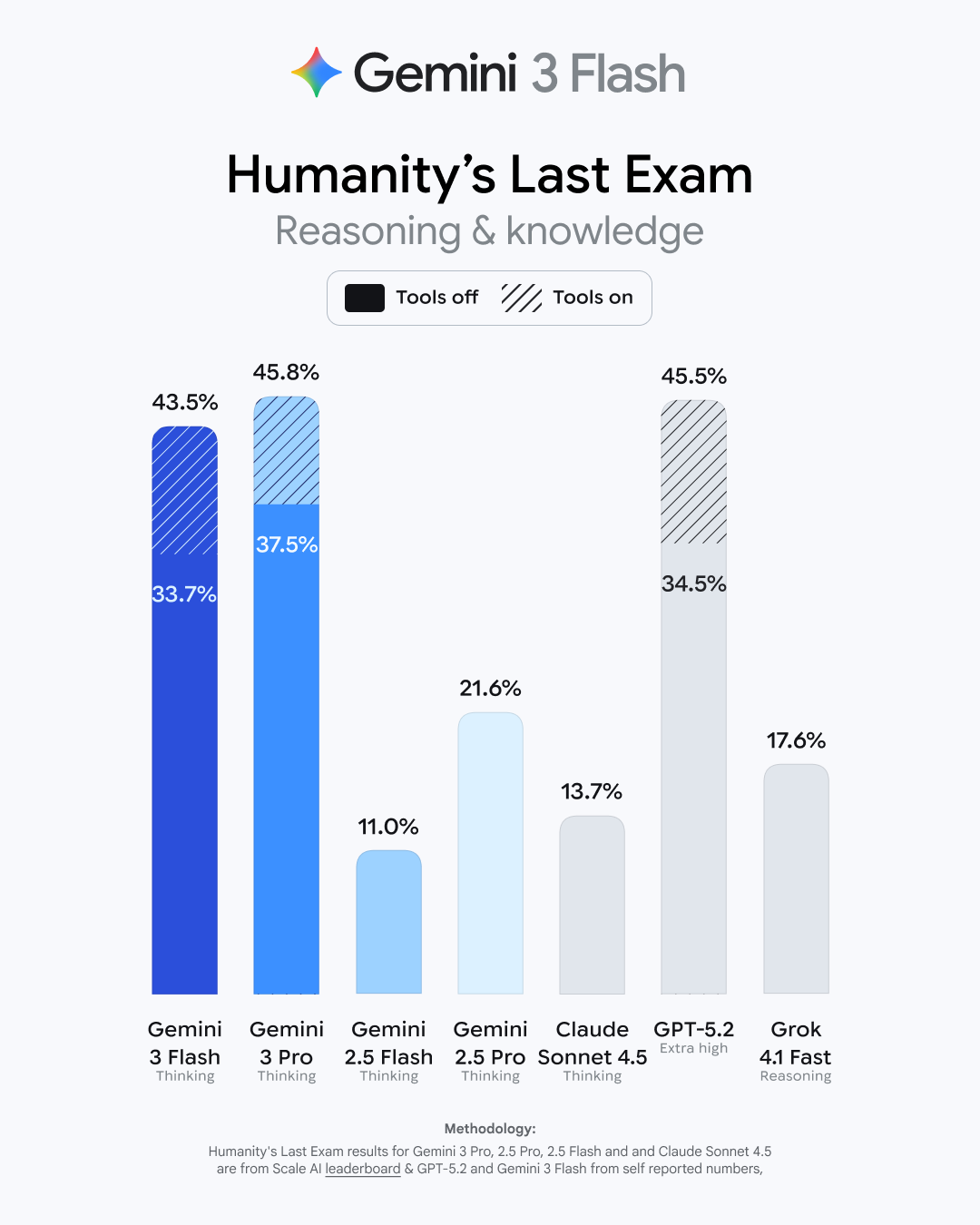

This may come as a shock, but Google says Gemini 3 Flash is faster and more capable than its previous base model. As usual, Google has a raft of benchmark numbers that show modest improvements for the new model. It bests the old 2.5 Flash in basic academic and reasoning tests like GPQA Diamond and MMMU Pro (where it even beats 3 Pro). It gets a larger boost in Humanity’s Last Exam (HLE), which tests advanced domain-specific knowledge. Gemini 3 Flash has tripled the old models’ score in HLE, landing at 33.7 percent without tool use. That’s just a few points behind the Gemini 3 Pro model.

-

Browser extensions with 8 million users collect extended AI conversations

Browser extensions with more than 8 million installs are harvesting complete and extended conversations from users’ AI conversations and selling them for marketing purposes, according to data collected from the Google and Microsoft pages hosting them.

Security firm Koi discovered the eight extensions, which as of late Tuesday night remained available in both Google’s and Microsoft’s extension stores. Seven of them carry “Featured” badges, which are endorsements meant to signal that the companies have determined the extensions meet their quality standards. The free extensions provide functions such as VPN routing to safeguard online privacy and ad blocking for ad-free browsing. All provide assurances that user data remains anonymous and isn’t shared for purposes other than their described use.

A gold mine for marketers and data brokers

An examination of the extensions’ underlying code tells a much more complicated story. Each contains eight of what Koi calls “executor” scripts, with each being unique for ChatGPT, Claude, Gemini, and five other leading AI chat platforms. The scripts are injected into webpages anytime the user visits one of these platforms. From there, the scripts override browsers’ built-in functions for making network requests and receiving responses.

-

Amazon appoints longtime AWS exec Peter DeSantis to lead new AI org

DeSantis has spent 27 years at Amazon, including eight years as an SVP for AWS, the cloud provider that powers about one-third of the internet. -

AI 语境下:多模态设计思考

多模态交互正重塑人机互动的未来,从单一感官通道到视觉、听觉、触觉的融合,AI技术让交互方式无限接近真实世界的自然交流。本文将深入探讨多模态交互的定义、优势、理论基础及设计挑战,揭示其如何在不同场景中提升用户体验,以及在未来人机交互中的潜力与局限。

随着 AI 时代的到来,越来越多的产品实现了从单一模态的交互到多模态交互的跨越。逐渐涌现的多模态大模型、具身智能等,让我们不再局限在单一维度的人机交互。

AI 时代下的人机交互正无限接近于真实世界的人与人之间的自然交流,为用户提供多维度的输入输出能力及情感反馈。

01 多模态交互的定义

模态:多重感官通道

在人机交互(HCI)领域,“模态”(Modality)一词有两种常见的含义:

- 指感官通道或输入输出通道:人机交互中所使用的感官通道。例如:视觉、听觉、触觉等。例如我们通过触控点击操作手机屏幕、通过对话控制智能音箱播放音乐。

- 指界面状态:聚焦某种界面状态,暂时锁定其他功能。例如我们经常使用的游戏菜单,必须要关闭菜单后,才能继续游戏,菜单就是一种模态状态。本文围绕第一种含义感官通道而展开探讨。

单模态交互

单模态交互(Unimodal Interaction)是指用户与系统之间仅通过单一感官通道(如视觉、听觉、触觉等)进行信息输入或输出的交互方式。例如:我们通过键盘输入文字,屏幕展示文字,传递单一视觉通道的信息。

多模态交互

想象一下,夏日傍晚走过一段热闹街区,我们能观察到沿街餐厅的布置,闻到食物飘散的香味,听见人群的谈笑声,同时还能品尝手中的饮料,所以人与环境、人与人天然就是多模态的交互。

我们理解多模态交互定义之前,先明确三个概念:感官、媒介、模态:

- 感官:人类的感官包含视觉、听觉、嗅觉、味觉、触觉等,是我们获取去外界信息的通道。

- 媒介:传播信息的载体,例如:文字、图片、视频、音频;媒介是连接模态与感官的载体。

- 模态:感官通道、输入输出通道。

多模态交互定义(Multimodal Interaction) 是指用户与系统之间通过多种感官通道或交互方式(如语音、视觉、触控、手势等)协同完成信息输入、处理和输出的过程。

02 现状与优势

多模态交互从1979年首次提出发展至今,PC 时代”Put That There”首次将语音和手势交互相结合,开创了多模态交互的先河。后续多模态交互逐渐应用在:智能手机、智能音箱、智能眼镜等产品形态。2024年,Open AI 发布的原生多模态大模型,支持语音和视觉的实时交互。它能够很好的理解用户语音中的语调和情感,并以富有情感化的语气、笑声进行回应。同年,谷歌也发布了支持实时视觉与语音交互的多模态手机助理。

谷歌多模态大模型:支持视觉和语音实时问答

多模态交互得以快速发展的原因:一、与多模态交互相关的 AI 算法逐渐成熟,包括语音识别、自然语言理解和计算机视觉技术;出现“会听、会说、会看、会写”的多模态大语言模型。二、AI 芯片和传感器能力增强与成本的下降。两者为多模态交互的推理能力和感知能力奠定了技术基础。

“理想的界面是没有界面。计算机可以给我:我所想的东西、或者我应该考虑的东西。”—— 来源:Van Dam, Post-WIMP User Interface,1997

提供自然、直观的体验

多模态交互更贴近人类本能交互方式,可以通过对话、面部表情、肢体动作等表达自己的意图,而不是仅仅局限在单模态交互的方式。降低认知负荷,以智能音箱为例,对于正在咿呀学语的幼儿来说,通过对话方式让音箱播放音乐不仅有趣,而且比点击屏幕界面要简单得多,能让他们更轻松、直接地表达自己的意图。

提升灵活性与无障碍包容性

多模态交互提供多样化的输入输出模态,适应不同的人群需求。例如:在不方便操作手机的离手场景,用户可以通过语音执行指令;视障人群可以结合语音与手势进行交互;听障人群可以借助视觉与手势操作设备。

提升效率与鲁棒性

提升效率:多模态并行输入输出,不局限在单模态交互,提升交互效率。例如:现有的扫地机器人是围绕预设空间进行清理,在不远的未来,我们可以指着餐桌同时对扫地机器人说:“帮我清理一下餐桌下面的食物残渣。”通过手势和语音结合的多模态输入,提升输入效率。提升鲁棒性:在复杂多变的环境中,面对未知问题的抗干扰能力、容错性较强。例如:自动驾驶采用多传感器互补策略,通过摄像头、毫米波雷达、激光雷达等不同传感器的特性,识别交通信号灯、近距离障碍物等。

增强沉浸感

在增强现实(AR)、虚拟现实(MR)等应用中,通过视觉、声音、震动等多感官信息传输,能为用户营造更加身临其境的体验,从而提升其参与度和投入感。

03 多模态交互的理论基础

目前多模态交互的理论基础主要来自认知心理学领域,分别是:多重资源理论和记忆模型。

多重资源理论

多重资源理论(MRT)核心观点阐明了人的注意力不是单一维度,而是分布在多个维度(视觉、听觉、空间等感知)。

如果任务都集中在一个感知通道,会造成认知负荷。多模态交互正是基于不同感官通道的协同,降低用户负荷。我们在开车时,视觉通道需要:看路面;车机导航如果仍然需要用户:看屏幕后点击操作,会导致视觉通道拥挤,互相抢占资源。如果此时导航操作采用语音的方式,就避免了这个问题,让驾驶场景更加安全。

工作记忆模型

Baddeley 定义的工作记忆模型将人类短时认知加工分为:语音环路、视觉空间模版、情景缓冲区、中央执行系统。可以看到我们对于短期记忆的信息处理天然就是“多模态的”,从人类短期信息存储与加工机制的角度,论证了多模态交互也能减轻认知负荷、提升效率。

04 多模态交互的设计思考

回到用户体验层面,多模态交互需要考虑什么呢?

满足用户直觉化、个性化交互

我们熟悉的界面交互是采用固定的流程进行约束,用户去学习、适应不同的功能。遇到错误异常情况,需要按照预设的路径:选择返回重新开始。而多模态交互意味着更直觉化、个人化的输入方式,不同用户之间行为习惯导致的差异性巨大。

我们可以看到谷歌 Gemini 2.5 pro 对于多模态 AI 助理核心能力的定义是:

- Personal深度理解用户意图:上下文感知对话;

- Powerful多模态信息处理:内容检索、知识关联等;

- Proactive自主决策与执行:包含界面控制、通话协助。

例如:在一个修理单车的场景,用户可以与手机进行视觉加语言的实时多模态交互,用户可以随时查询墙面上单车零件信息,助理根据不同的指令自动化操作手机界面。当用户与其他朋友对话时候,AI 助理面对临时性的对话打断,也可以灵活的屏蔽非机主声音,等用户结束与他人的对话后,也可以完整的接续语境。

2025 谷歌 I/O 大会Gemini 2.5 pro

理解人类世界构建的文化基础

除了应对用户更直觉、随性的输入,再往深层考虑,AI 时代的多模态交互需要理解:贯穿于生活中常识性、约定俗成的规则、人类信仰等内容。

下面是心理学家兼语言学家斯蒂芬·平克(Steven Pinker)设计的一段简短对话:鲍勃:“我要离开你。”爱丽丝:“她是谁?”电视剧中经常出现这种对话,我们可以很容易的理解这段话意思,甚至可以推测出爱丽丝现在很生气。 但是让智能助手理解这段话并不简单,它需要理解贯穿于生活中的常识性规则、欲望和关系等等。

再举个手势设计的例子,“ok”这个手势在不同的国家有不同的含义:在中国、美国表示事情是妥妥的;在土耳其、希腊则是极具侮辱性的手势。所以多模态交互需要从对话、手势、视觉、声音等维度去考虑人类的信仰、文化背景。

具备动态学习能力

多模态交互在语音、触控、视觉的多维输入输出方式,让原本局限在手机屏幕内的界面交互向真实物理世界进行外延。设备可以感知物理世界的景象、声音,同时直接反馈给用户,让数字世界和物理世界开始深度融合。

真实物理世界是多变的,这就要求功能交互具备灵活的适应性、主动学习能力。正如 Rich Sutton 在 RLC 会议上表示物理世界是复杂的、非线性的、动态的。AI 要能够从运行中学习、规划、行动。

因为真正的 AI 与真实世界、人类进行交互的时候,会发现世界可能并不想原来预训练时所期望的那样,肯定无法完全预先了解、预见与世界互动交互所需要的所有复杂细节和所有抽象的概念。从中我们可以预见到动态学习、推理判断、执行能力是AI时代下多模态交互的基石。

“我想任何有意识的实体可能都期望:将自己设置成被无限可能地使用。”—— 来源:《2001太空漫游》

图左:特斯拉 Optimus

图右:树宇 H 型人形机器人

具身智能同样强调交互中的“动态适应”能力,能够在复杂、未知的环境中学习适应。通过“身体”的硬件与环境进行互动、实践,从而更贴近真实的人机交互场景。

平衡隐私与个性化

2025 谷歌 Android XR 智能眼镜

2025 年谷歌 I/O 大会上,发布了搭载 AI 助手的 Android XR 智能眼镜,通过设备端通过内置镜头、麦克风“听到、看到”输入信息,通过镜片内置显示屏、扬声器反馈导航信息。

“我们将迎来崭新的巨大平台,世间万物均可以与 AI(人工智能)链接,现实世界与数字化将完美融合,被称为镜像世界的 AR(增强现实)将会诞生”。—— 来源:凯文·凯利《5000天后的世界》

谷歌智能眼镜

左图:实时翻译

右图:导航

当多模态交互应用在智能眼镜、具身智能等场景,设备正在搜索、获取大量的非常个人化的数据,比如:你在你看什么、你的表情是什么、你做了什么动作、你所在位置、你周围的环境……所以我们应该更加注重用户隐私与个性化服务之间的平衡。

我们需要理解:一方面用户不希望自己的隐私数据被随意获取,另一方面想要获得个性化服务就必须提供相关数据。

那么平衡隐私与个性化这个天平的核心在于:互见性。即用户拥有知情权,可以从知道自己哪些数据被获取、被谁调用或访问。同时用户有途径通过公开透明的途径进行申诉的机制。这样一来,当用户才会让渡部分隐私权,提供多模态的个人数据从而获取更优质的个性化服务。

05 总结

本文系统性梳理了多模态交互的核心定义、独特优势、理论基础及设计思考。

在这个 AI 井喷式发展的时代语境下,变化的,是不断革新的硬件感知能力和多模态算法能力。促使多模态交互应用在手机、可穿戴设备、车载、具身智能等不同领域。

不变的,是我们对更自然、更真实的人机交互方式的探索。人类天然是通过视觉、声音、表情、动作传递信息和表达自我,而“多模态交互”的意义,正是让人机交互逐渐贴近人与人、人与原生世界的交互范式。

参考文献

- 薛志荣. 《前瞻交互:从语音、手势设计到多模融合》[M]. 电子工业出版社,2022.

- (英)迈克尔・伍尔德里奇. 《人工智能全传》[M]. 许舒 译。浙江科学技术出版社,2021.

- (美)凯文・凯利、吴晨. 《2049:未来 10000 天的可能》[M]. 中信出版集团,2025.

- Rich Sutton, The OaK Architecture: A Vision of SuperIntelligence from Experience – RLC 2025

图片来自网络公开资料,若涉及版权请联系修改。

本文由 @HAI Design 原创发布于人人都是产品经理。未经作者许可,禁止转载

题图来自Unsplash,基于CC0协议

该文观点仅代表作者本人,人人都是产品经理平台仅提供信息存储空间服务

-

GPT-5.2功能范式!让产品经理的我看到哪些机会点?

GPT-5.2的发布标志着AI从工具到智能体的革命性跨越。40万Token的上下文容量、增强的多模态能力与深度推理功能,正在重塑产品设计的底层逻辑。本文将剖析如何通过容错设计、角色化交互与主动协作机制,让这一代AI在中国本土场景中真正发挥’超级助理’的价值。

GPT-5.2于2025年末发布,是OpenAI对GPT-5系列的重要升级。与之前版本相比,它在多方面有质的提升:

- 上下文容量更大,旗舰版上下文窗口高达40万Token;多模态能力增强,不仅能读文本,还更擅长识别屏幕截图、图表、UI界面并提取结构化信息;

- 推理能力升级,引入更深层次的思维链和多级“推理投入”调节(新增xhigh级别);

- 工具与智能体调用更加灵活,在API中提供新的参数和上下文压缩功能。

OpenAI指出,GPT-5.2并非简单“更大的聊天模型”,而是由Instant/Thinking/Pro三个变体构成的多模态智能体家族,针对长文档推理、工具调用和视觉理解等任务进行优化。

这些底层升级带来了一场功能范式的变革:产品不再只是给模型“按钮 + 功能”,而是与一个可“扮演角色”的智能体协作。GPT-5.2让AI在复杂工作流中表现更像“超级助理”而不是单点工具。

接下来,我将从容错与场景、功能向角色迁移、主动交互设计以及商业模式等角度,结合中国本土视角,深度拆解GPT-5.2对产品的影响和机遇。

技术升级重新定义“可用性”

GPT-5.2的提升虽多,但仍不可能保证100%正确。这样的场景下,产品经理必须重新思考可用性:如何通过容错设计、场景选择和预期管理,让“非完美”AI依然产生价值?

容错设计:AI本质上是“概率引擎”,回答可能多种多样。产品不应给出绝对结论,而应设计防错机制。例如,在推荐场景中,可加注说明“基于历史行为推荐,仅供参考”;提供多个备选答案让用户选择。对医疗、法律等要求严谨的应用,还要提供解释信息,如“贷款被拒,因为负债率过高”,而不是简单拒绝。在界面设计上,团队应避免对AI结果生搬硬套,鼓励“微调-试错-迭代”的非线性开发方式,不断通过用户反馈优化模型。

场景选择:针对不同风险级别灵活应用。知名PM指南将场景分为“红灯、黄灯、绿灯”三类:在高风险场景如金融审批、医疗诊断等,AI结果必须人机回环——AI给出建议,最终由人审核并解释;而在低风险场景如垃圾邮件过滤、游戏NPC等,则可让AI直接输出,只需标注“AI生成”即可。这样既利用了AI效率,也控制了误伤风险。总之,应优先选择容错度高、受益大于风险的任务来部署GPT-5.2,避免在关键任务上盲目全权交给AI。

用户预期管理:面对准确率,必须主动引导用户认知AI局限。交互层面要透明化AI身份与可信度:界面上明确标注“××由AI生成”,并可展示模型置信度或信息来源。文案上要提醒用户“我可能会错,请您核实重要信息”,切忌宣传“100%正确”。用户应保持决策权:AI生成结果可让用户编辑、删除、撤销;对于如自动发送邮件等高风险操作,需二次确认而非自动执行。此外,及时的反馈闭环也很重要:在每条AI回答后增加“点赞/点踩”按钮和问题分类(如“不相关”“过时”“有害”),将用户纠错反馈纳入训练流程,让系统“越用越准”。

通过上述设计,产品既能利用GPT-5.2的长处,又能让用户在“模糊结果”中找到容错空间和信心,从而真正“可用”。

从功能到“智能体”

GPT-5.2带来的另一个革命是产品交互范式的变化:从传统的“按钮+功能”界面,向“角色+动作”的智能体交互迁移。即产品不再把AI当成黑盒工具,而是赋予它具体角色,让用户像指挥助手一样与之对话、协作。

以下结合国内常见场景举例说明:

智能办公助手:以办公软件为例。过去我们在办公套件里要手动选菜单生成报告、图表;如今可以让GPT-5.2以“资深助理”身份介入。钉钉ONE等平台已经推出了AI办公助手,例如自动生成文档和会议纪要、自动构建知识库并智能检索信息。

下图显示了GPT-5.1(左)与GPT-5.2(右)在自动创建“人力规划模型”表格时的对比:GPT-5.2生成的表格布局更专业、细节更完善,错误率更低。

如上图所示,用户仅输入高层需求,GPT-5.2便能生成规范的电子表格报表。Office产品经理可以将此类“AI助手”整合到工具栏或对话框中,让用户像和同事沟通一样,只需输入“帮我写份简报”或“列出PPT大纲”,AI便能快速交付内容,省去繁琐操作。

智能客户关系管理(CRM):传统CRM更多是记录系统,业务人员要靠自己查询客户信息和商机。GPT-5.2能将CRM升级为“智能经营中枢“。模型可主动分析客户数据并自动完成筛选、评分与推荐:比如它会自动标记最有成交可能的潜在客户、提醒应跟进的客户;在销售过程中,AI助理还能自动撰写跟进邮件、生成沟通话术。

换言之,GPT-5.2不再是后端计算,而是变成一名“销售助理”:它查看客户资料、建议行动计划、甚至发起自动触达。产品设计上,可以给用户一个角色+动作入口,比如“智能商务助理”对话窗口或自动提醒推送,把原本孤立的查询功能变为AI主动输出。

内容创作平台:在媒体或营销平台中,GPT-5.2可以化身“智能写手”或“创意编辑”。例如国内星光AI助手等已经支持“一键生成营销文本、配图和短视频脚本等多类型内容”。内容平台可以集成GPT-5.2,让用户只需提供主题、风格要求,AI便能完成从标题、正文到配图、脚本的整个创作动作。产品上这意味着“发布按钮”前增加AI步骤:用户点击“生成稿件”,后端AI智能体会生成初稿,用户再对稿件做微调和审核。这样设计下,GPT-5.2不只是一个工具按钮,而是扮演了“内容策划师”、“视频编导”等角色,与用户展开角色扮演式交互。

总的来说,在新范式下,产品由单一功能集合变为“多Agent生态”,用户不再手动串联功能流程,而是对话式地分配任务、审阅结果。这种转变要求产品经理在设计时把AI当成人物角色,规划它的行为方式和边界,从而让GPT-5.2的能力真正融入业务场景。

未来已来——主动性、异步性与“教育”用户

GPT-5.2带来了新的设计理念:AI可以主动发力、异步反馈并引导用户学习使用,这对国内用户行为特点提出了新要求。中国用户习惯即时响应、不喜欢多余操作,因而产品需要巧妙地将“智能体”能力与用户体验结合:

AI主动提示:智能体可在用户尚未察觉前主动提供建议。比如,当用户输入“帮我安排会议”时,AI不仅给出初步日程,还会主动问“您偏好周几开会?”、“需要多长时间?”等引导性问题,形成多轮协作。在界面设计上,可通过悬浮提示、侧边栏建议等形式,让AI时时“盯着”用户需求,及时抛出补充信息与选项,而不是等用户按“执行”后再被动响应。此外,对于如支付、提交等关键操作,AI应主动请求用户确认,以可控的方式教育用户:AI即使可以自动完成,系统也要让用户插入判断,确保用户习惯逐步过渡,透明而有参与感。

异步反馈:对于需要较长时间处理的任务(如大文档分析、复杂调用等),产品可以设计异步模式,改善中国用户的耐心阈值。比如用户提交生成需求后,系统应立即给出视觉反馈(如“我们正在努力生成中…”),而不是让用户空等。生成过程可以分阶段展示:第一阶段先返回部分结果或大纲,用户确认无误后继续深入细节。产品可以引入进度条、子任务清单等形式,让用户感觉到AI在“持续工作”,而非长时间毫无响应。加速首字生成时间和输出流畅度也是关键:研究建议聊天场景首字响应应控制在200ms以内,否则用户会认为系统“卡住了”。GPT-5.2本身性能更强,但在产品设计中仍要利用加载动画等策略及时给用户反馈,满足喜欢“秒回”的使用习惯。

延迟回报式学习:面向不断提升用户对AI的熟悉度,可设计渐进式奖励机制。例如对首次尝试AI功能的用户,给予操作指引或引导教程,一步步展示GPT-5.2的能力和边界;同时通过游戏化元素(如成就徽章、等级体系)鼓励用户多尝试多反馈,形成闭环学习。产品可以记录用户历史输入与AI反馈情况,利用GPT-5.2的记忆能力,在后续会话中自动复用已验证有效的方案。这样用户在与AI互动中逐渐建立信任:因为系统“越用越聪明”,他们看到自己的反馈被采纳。结合“即时反馈+渐进学习”的设计,既满足了用户一开始希望快速见效的需求,也逐步教育用户拥抱AI协作的工作方式。

简言之,新交互下用户像队友一样与AI共事,需要产品在设计上强化协同与教育功能。借鉴微软Magentic-UI等前沿实践:如其“共策划工作流设计器”让人机共同制定每一步方案,用户可随时修改、确认、介入;界面实时显示AI操作,让用户清楚看到AI在做什么。这些设计有助于“教学”用户理解AI行为、建立信任。面对用户“不喜欢多步骤但爱即时响应”的特点,合理平衡主动协作与简洁流程,将GPT-5.2无缝融入产品中,就是关键的一课。

结语:PM的我们,可以做什么?

GPT-5.2带来了新一代的功能范式跃迁:产品经理不再是单纯的“功能配置师”,而要成为AI的“调教师”和协作设计师。在这个过程中,PM需要完成思维转变:

①从“功能交付”到“效果交付”,关注AI提升效率、降低错误率等实际效果;

②从“确定性思维”到“概率思维”,习惯在不完美中寻优,并在成本、速度、质量间权衡;

③从“孤立工具”到“智能体生态”,设计由多个角色协作完成任务的新型应用。正如业内总结:“AI时代PM的核心竞争力,不是用了多牛的模型,而是懂不懂‘数据策展’、会不会‘模型选型’、能不能‘风险控制’”。未来的产品经理更像是一名模型教练:他们要训练和微调GPT-5.2,设置合理的提示和回路,让AI能力持续进化;同时与设计师、数据工程师一同塑造人机协作体验,强化反馈学习,让每一次交互都朝着更智能的方向迭代。

拥抱GPT-5.2,就是拥抱智能涌现的时代。通过合适的设计和场景落地,我们可以让这一代模型既“靠谱”又“接地气”,为用户提供新颖有趣又切实可行的产品体验。在日新月异的AI浪潮中,未来产品的制胜之道,不仅是打磨功能本身,更在于驾驭模型、编织协作,让智能真正成为用户无形中最坚实的助力。

本文由 @兔主任观测员 原创发布于人人都是产品经理。未经作者许可,禁止转载

题图来自Unsplash,基于CC0协议