多模态交互正重塑人机互动的未来,从单一感官通道到视觉、听觉、触觉的融合,AI技术让交互方式无限接近真实世界的自然交流。本文将深入探讨多模态交互的定义、优势、理论基础及设计挑战,揭示其如何在不同场景中提升用户体验,以及在未来人机交互中的潜力与局限。

随着 AI 时代的到来,越来越多的产品实现了从单一模态的交互到多模态交互的跨越。逐渐涌现的多模态大模型、具身智能等,让我们不再局限在单一维度的人机交互。

AI 时代下的人机交互正无限接近于真实世界的人与人之间的自然交流,为用户提供多维度的输入输出能力及情感反馈。

01 多模态交互的定义

模态:多重感官通道

在人机交互(HCI)领域,“模态”(Modality)一词有两种常见的含义:

- 指感官通道或输入输出通道:人机交互中所使用的感官通道。例如:视觉、听觉、触觉等。例如我们通过触控点击操作手机屏幕、通过对话控制智能音箱播放音乐。

- 指界面状态:聚焦某种界面状态,暂时锁定其他功能。例如我们经常使用的游戏菜单,必须要关闭菜单后,才能继续游戏,菜单就是一种模态状态。本文围绕第一种含义感官通道而展开探讨。

单模态交互

单模态交互(Unimodal Interaction)是指用户与系统之间仅通过单一感官通道(如视觉、听觉、触觉等)进行信息输入或输出的交互方式。例如:我们通过键盘输入文字,屏幕展示文字,传递单一视觉通道的信息。

多模态交互

想象一下,夏日傍晚走过一段热闹街区,我们能观察到沿街餐厅的布置,闻到食物飘散的香味,听见人群的谈笑声,同时还能品尝手中的饮料,所以人与环境、人与人天然就是多模态的交互。

我们理解多模态交互定义之前,先明确三个概念:感官、媒介、模态:

- 感官:人类的感官包含视觉、听觉、嗅觉、味觉、触觉等,是我们获取去外界信息的通道。

- 媒介:传播信息的载体,例如:文字、图片、视频、音频;媒介是连接模态与感官的载体。

- 模态:感官通道、输入输出通道。

多模态交互定义(Multimodal Interaction) 是指用户与系统之间通过多种感官通道或交互方式(如语音、视觉、触控、手势等)协同完成信息输入、处理和输出的过程。

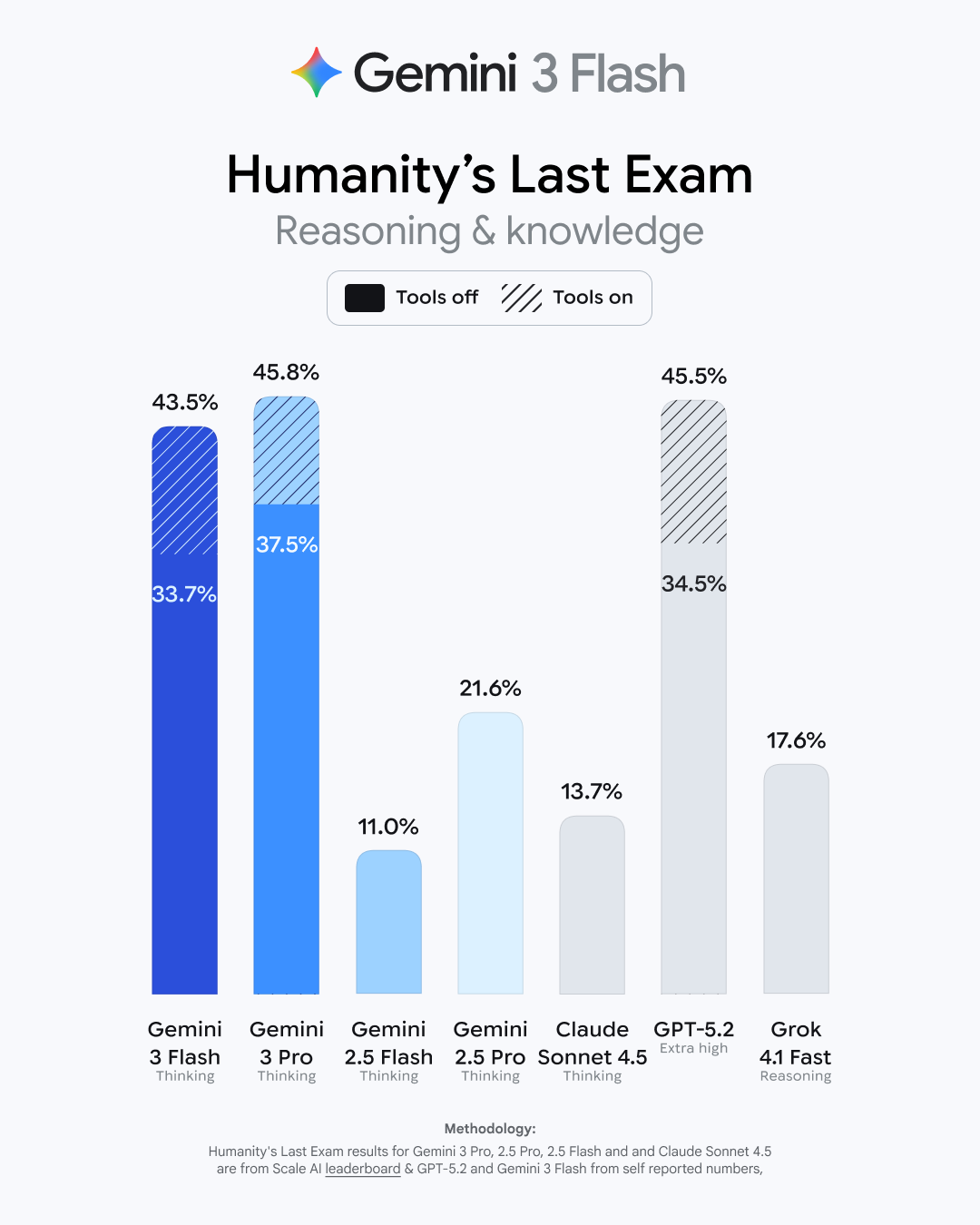

02 现状与优势

多模态交互从1979年首次提出发展至今,PC 时代”Put That There”首次将语音和手势交互相结合,开创了多模态交互的先河。后续多模态交互逐渐应用在:智能手机、智能音箱、智能眼镜等产品形态。2024年,Open AI 发布的原生多模态大模型,支持语音和视觉的实时交互。它能够很好的理解用户语音中的语调和情感,并以富有情感化的语气、笑声进行回应。同年,谷歌也发布了支持实时视觉与语音交互的多模态手机助理。

谷歌多模态大模型:支持视觉和语音实时问答

多模态交互得以快速发展的原因:一、与多模态交互相关的 AI 算法逐渐成熟,包括语音识别、自然语言理解和计算机视觉技术;出现“会听、会说、会看、会写”的多模态大语言模型。二、AI 芯片和传感器能力增强与成本的下降。两者为多模态交互的推理能力和感知能力奠定了技术基础。

“理想的界面是没有界面。计算机可以给我:我所想的东西、或者我应该考虑的东西。”—— 来源:Van Dam, Post-WIMP User Interface,1997

提供自然、直观的体验

多模态交互更贴近人类本能交互方式,可以通过对话、面部表情、肢体动作等表达自己的意图,而不是仅仅局限在单模态交互的方式。降低认知负荷,以智能音箱为例,对于正在咿呀学语的幼儿来说,通过对话方式让音箱播放音乐不仅有趣,而且比点击屏幕界面要简单得多,能让他们更轻松、直接地表达自己的意图。

提升灵活性与无障碍包容性

多模态交互提供多样化的输入输出模态,适应不同的人群需求。例如:在不方便操作手机的离手场景,用户可以通过语音执行指令;视障人群可以结合语音与手势进行交互;听障人群可以借助视觉与手势操作设备。

提升效率与鲁棒性

提升效率:多模态并行输入输出,不局限在单模态交互,提升交互效率。例如:现有的扫地机器人是围绕预设空间进行清理,在不远的未来,我们可以指着餐桌同时对扫地机器人说:“帮我清理一下餐桌下面的食物残渣。”通过手势和语音结合的多模态输入,提升输入效率。提升鲁棒性:在复杂多变的环境中,面对未知问题的抗干扰能力、容错性较强。例如:自动驾驶采用多传感器互补策略,通过摄像头、毫米波雷达、激光雷达等不同传感器的特性,识别交通信号灯、近距离障碍物等。

增强沉浸感

在增强现实(AR)、虚拟现实(MR)等应用中,通过视觉、声音、震动等多感官信息传输,能为用户营造更加身临其境的体验,从而提升其参与度和投入感。

03 多模态交互的理论基础

目前多模态交互的理论基础主要来自认知心理学领域,分别是:多重资源理论和记忆模型。

多重资源理论

多重资源理论(MRT)核心观点阐明了人的注意力不是单一维度,而是分布在多个维度(视觉、听觉、空间等感知)。

如果任务都集中在一个感知通道,会造成认知负荷。多模态交互正是基于不同感官通道的协同,降低用户负荷。我们在开车时,视觉通道需要:看路面;车机导航如果仍然需要用户:看屏幕后点击操作,会导致视觉通道拥挤,互相抢占资源。如果此时导航操作采用语音的方式,就避免了这个问题,让驾驶场景更加安全。

工作记忆模型

Baddeley 定义的工作记忆模型将人类短时认知加工分为:语音环路、视觉空间模版、情景缓冲区、中央执行系统。可以看到我们对于短期记忆的信息处理天然就是“多模态的”,从人类短期信息存储与加工机制的角度,论证了多模态交互也能减轻认知负荷、提升效率。

04 多模态交互的设计思考

回到用户体验层面,多模态交互需要考虑什么呢?

满足用户直觉化、个性化交互

我们熟悉的界面交互是采用固定的流程进行约束,用户去学习、适应不同的功能。遇到错误异常情况,需要按照预设的路径:选择返回重新开始。而多模态交互意味着更直觉化、个人化的输入方式,不同用户之间行为习惯导致的差异性巨大。

我们可以看到谷歌 Gemini 2.5 pro 对于多模态 AI 助理核心能力的定义是:

- Personal深度理解用户意图:上下文感知对话;

- Powerful多模态信息处理:内容检索、知识关联等;

- Proactive自主决策与执行:包含界面控制、通话协助。

例如:在一个修理单车的场景,用户可以与手机进行视觉加语言的实时多模态交互,用户可以随时查询墙面上单车零件信息,助理根据不同的指令自动化操作手机界面。当用户与其他朋友对话时候,AI 助理面对临时性的对话打断,也可以灵活的屏蔽非机主声音,等用户结束与他人的对话后,也可以完整的接续语境。

2025 谷歌 I/O 大会Gemini 2.5 pro

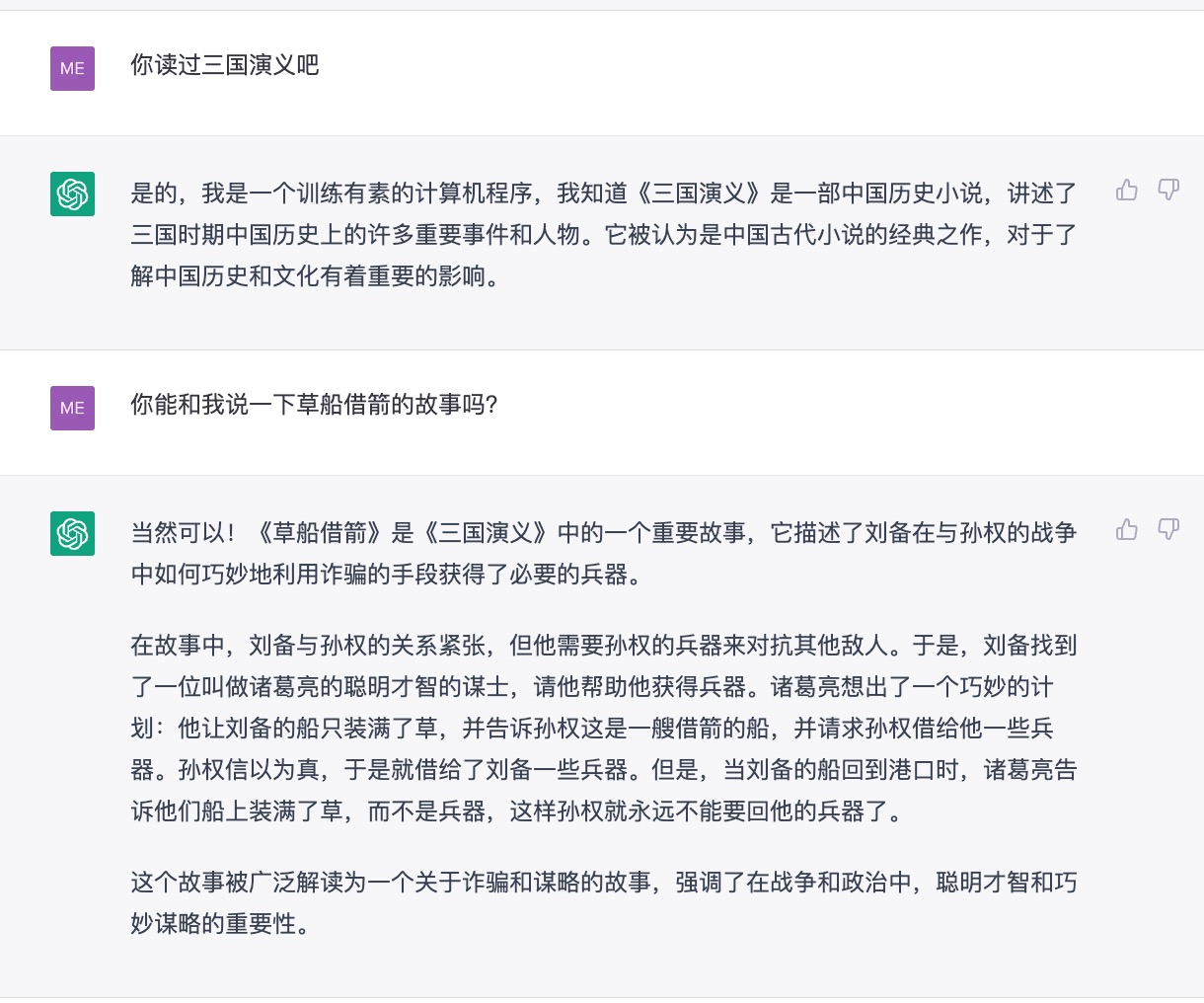

理解人类世界构建的文化基础

除了应对用户更直觉、随性的输入,再往深层考虑,AI 时代的多模态交互需要理解:贯穿于生活中常识性、约定俗成的规则、人类信仰等内容。

下面是心理学家兼语言学家斯蒂芬·平克(Steven Pinker)设计的一段简短对话:鲍勃:“我要离开你。”爱丽丝:“她是谁?”电视剧中经常出现这种对话,我们可以很容易的理解这段话意思,甚至可以推测出爱丽丝现在很生气。 但是让智能助手理解这段话并不简单,它需要理解贯穿于生活中的常识性规则、欲望和关系等等。

再举个手势设计的例子,“ok”这个手势在不同的国家有不同的含义:在中国、美国表示事情是妥妥的;在土耳其、希腊则是极具侮辱性的手势。所以多模态交互需要从对话、手势、视觉、声音等维度去考虑人类的信仰、文化背景。

具备动态学习能力

多模态交互在语音、触控、视觉的多维输入输出方式,让原本局限在手机屏幕内的界面交互向真实物理世界进行外延。设备可以感知物理世界的景象、声音,同时直接反馈给用户,让数字世界和物理世界开始深度融合。

真实物理世界是多变的,这就要求功能交互具备灵活的适应性、主动学习能力。正如 Rich Sutton 在 RLC 会议上表示物理世界是复杂的、非线性的、动态的。AI 要能够从运行中学习、规划、行动。

因为真正的 AI 与真实世界、人类进行交互的时候,会发现世界可能并不想原来预训练时所期望的那样,肯定无法完全预先了解、预见与世界互动交互所需要的所有复杂细节和所有抽象的概念。从中我们可以预见到动态学习、推理判断、执行能力是AI时代下多模态交互的基石。

“我想任何有意识的实体可能都期望:将自己设置成被无限可能地使用。”—— 来源:《2001太空漫游》

图左:特斯拉 Optimus

图右:树宇 H 型人形机器人

具身智能同样强调交互中的“动态适应”能力,能够在复杂、未知的环境中学习适应。通过“身体”的硬件与环境进行互动、实践,从而更贴近真实的人机交互场景。

平衡隐私与个性化

2025 谷歌 Android XR 智能眼镜

2025 年谷歌 I/O 大会上,发布了搭载 AI 助手的 Android XR 智能眼镜,通过设备端通过内置镜头、麦克风“听到、看到”输入信息,通过镜片内置显示屏、扬声器反馈导航信息。

“我们将迎来崭新的巨大平台,世间万物均可以与 AI(人工智能)链接,现实世界与数字化将完美融合,被称为镜像世界的 AR(增强现实)将会诞生”。—— 来源:凯文·凯利《5000天后的世界》

谷歌智能眼镜

左图:实时翻译

右图:导航

当多模态交互应用在智能眼镜、具身智能等场景,设备正在搜索、获取大量的非常个人化的数据,比如:你在你看什么、你的表情是什么、你做了什么动作、你所在位置、你周围的环境……所以我们应该更加注重用户隐私与个性化服务之间的平衡。

我们需要理解:一方面用户不希望自己的隐私数据被随意获取,另一方面想要获得个性化服务就必须提供相关数据。

那么平衡隐私与个性化这个天平的核心在于:互见性。即用户拥有知情权,可以从知道自己哪些数据被获取、被谁调用或访问。同时用户有途径通过公开透明的途径进行申诉的机制。这样一来,当用户才会让渡部分隐私权,提供多模态的个人数据从而获取更优质的个性化服务。

05 总结

本文系统性梳理了多模态交互的核心定义、独特优势、理论基础及设计思考。

在这个 AI 井喷式发展的时代语境下,变化的,是不断革新的硬件感知能力和多模态算法能力。促使多模态交互应用在手机、可穿戴设备、车载、具身智能等不同领域。

不变的,是我们对更自然、更真实的人机交互方式的探索。人类天然是通过视觉、声音、表情、动作传递信息和表达自我,而“多模态交互”的意义,正是让人机交互逐渐贴近人与人、人与原生世界的交互范式。

参考文献

- 薛志荣. 《前瞻交互:从语音、手势设计到多模融合》[M]. 电子工业出版社,2022.

- (英)迈克尔・伍尔德里奇. 《人工智能全传》[M]. 许舒 译。浙江科学技术出版社,2021.

- (美)凯文・凯利、吴晨. 《2049:未来 10000 天的可能》[M]. 中信出版集团,2025.

- Rich Sutton, The OaK Architecture: A Vision of SuperIntelligence from Experience – RLC 2025

图片来自网络公开资料,若涉及版权请联系修改。

本文由 @HAI Design 原创发布于人人都是产品经理。未经作者许可,禁止转载

题图来自Unsplash,基于CC0协议

该文观点仅代表作者本人,人人都是产品经理平台仅提供信息存储空间服务